NVIDIA 在微软 Ignite 2023 技术大会带来多项发布!极大推动人工智能技术发展!

微软首席执行官 Satya Nadella 和 NVIDIA 创始人兼首席执行官黄仁勋也在微软 Ignite 2023 技术大会上登台亮相。本文将带您了解这次的新发布,探索其中的创新亮点。

企业级生成式 AI

NVIDIA 在 Microsoft Azure 上推出面向全球企业和初创公司的生成式 AI Foundry 服务

点击链接即可阅读全文

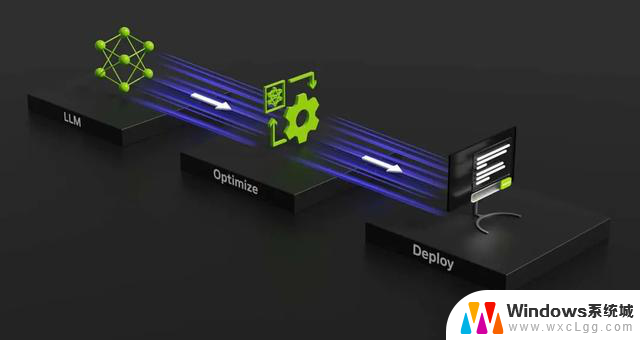

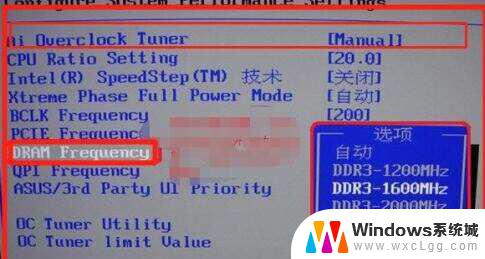

NVIDIA 推出一项 AI foundry 服务,助力企业和初创公司在 Microsoft Azure 上开发、调优和部署其自定义生成式 AI 应用。

这项 NVIDIA AI foundry 服务整合了 NVIDIA AI Foundation Models、NVIDIA NeMo™ 框架和工具,以及 NVIDIA DGX™ 云 AI 超算服务三大要素,为企业提供创建自定义生成式 AI 模型的端到端解决方案,并且支持企业使用 NVIDIA AI Enterprise 软件部署其定制模型,以支持生成式 AI 应用,包括智能搜索、摘要和内容生成。

NVIDIA 创始人兼首席执行官黄仁勋表示:“企业需要自定义模型来执行基于公司专有 DNA (即数据)训练的专业技能。NVIDIA 的 AI foundry 服务整合了我们的生成式 AI 模型技术、LLM 训练的专业知识和超大型 AI 工厂。我们在 Microsoft Azure 中构建这项服务,使全世界的企业都能够将他们的自定义模型与微软全球领先的云服务进行连接。”

NVIDIA 加快企业自定义生成式 AI 模型开发

点击链接即可阅读全文

NVIDIA AI Foundation Models 集企业级预训练模型之大成,为开发人员提供了针对企业应用定制生成式 AI 的良好开端。

NVIDIA AI Foundation Models 可通过简单的用户界面或 API 直接在浏览器体验。此外,这些模型还可通过 NVIDIA AI Foundation Endpoints 进行访问,以便在企业应用中测试模型性能。

NVIDIA 开发检索增强生成参考架构

点击链接即可阅读全文

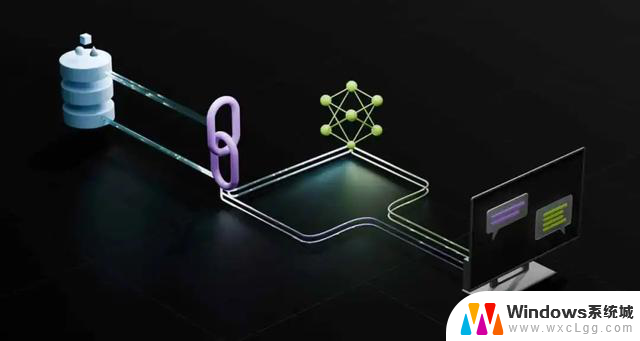

NVIDIA 开发了检索增强生成参考架构。该架构包含一个聊天机器人示例和用户使用这种新方法创建个人应用所需的元素。

该工作流使用了专用于开发和自定义生成式 AI 模型的框架 NVIDIA NeMo,以及用于在生产中运行生成式 AI 模型的软件,例如 NVIDIA Triton 推理服务器和 NVIDIA TensorRT-LLM 等。

这些软件组件均包含在 NVIDIA AI Enterprise 软件平台中,其可加速生产就绪型 AI 的开发和部署,并提供企业所需的安全性、支持和稳定性。

NVIDIA 与 Amdocs 为全球电信行业

带来自定义生成式 AI

点击链接即可阅读全文

NVIDIA AI foundry 服务集合了 NVIDIA AI Foundation Models、NVIDIA NeMo 框架和工具以及 NVIDIA DGX Cloud AI 超级计算和服务,为企业提供了一套端到端解决方案。用于创建并优化自定义生成式 AI 模型。

借助这项 AI foundry 服务,领先的通信和媒体提供商与软件和服务提供商 Amdocs 将为电信和媒体行业优化企业级大语言模型(LLM),以便在其从客户体验到网络运营和供应等业务领域有效部署生成式 AI 用例。LLM 将作为 Amdocs amAIz 框架的一部分,在 NVIDIA 加速计算上运行。

该合作以此前宣布的 Amdocs - 微软的合作伙伴关系为基础,使服务提供商能够在安全、可信的环境中采用这些应用,包括在本地和云中。

Omniverse

NVIDIA 宣布在 Microsoft Azure 上提供 Omniverse Cloud 服务,

加速汽车行业的数字化进程

点击链接即可阅读全文

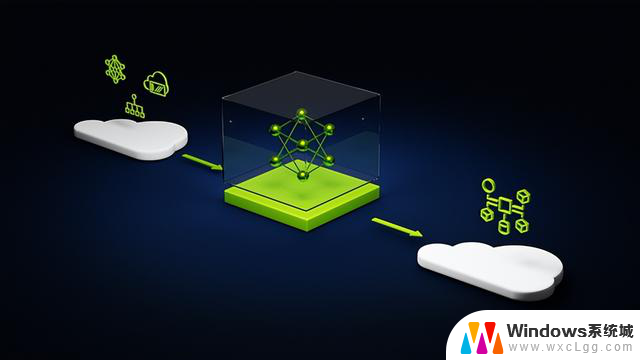

NVIDIA 在 Omniverse Cloud 上发布了两个全新的仿真引擎:虚拟工厂仿真引擎和自动驾驶汽车(AV)仿真引擎。

Omniverse Cloud 是一项用于开发和部署工业数字化应用的平台即服务(PaaS,platform-as-a-service),这项服务现已托管在 Microsoft Azure 上。该一站式服务能够使全球汽车制造商统一其核心产品与业务流程的数字化,从而提高生产速度和运营效率,缩短产品上市时间,推进可持续性计划。

Omniverse Cloud 虚拟工厂仿真引擎整合了一系列可自定义的开发者应用和服务,使工厂规划团队能够在连接大规模工业数据集的同时,进行实时协作、浏览和审核。

自动驾驶汽车仿真引擎实现了符合物理学的传感器仿真,该服务使自动驾驶和机器人开发者能够在闭环虚拟环境中运行自主系统。

RTX

TensorRT-LLM 更新加速 AI 推理性能,支持在 RTX 驱动的 Windows PC 上运行新模型

点击链接即可阅读全文

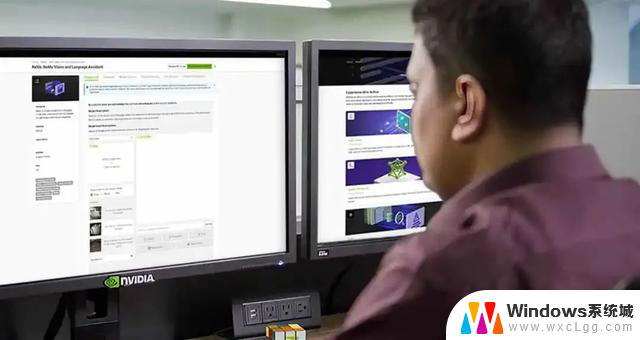

NVIDIA 发布的全新优化、模型和资源将更快地帮助开发者提供新的终端用户体验。

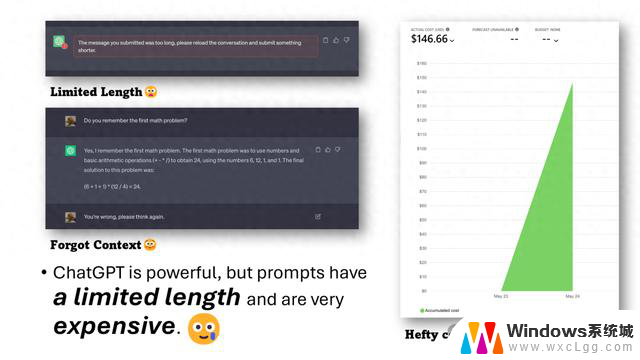

TensorRT-LLM 是一款提升 AI 推理性能的开源软件,它即将发布的更新将支持更多大语言模型,在 RTX GPU 8GB 及以上显存的 PC 和笔记本电脑上使要求严苛的 AI 工作负载更容易完成。

Tensor RT-LLM for Windows 即将通过全新封装接口与 OpenAI 广受欢迎的聊天 API 兼容。这将使数以百计的开发者项目和应用能在 RTX PC 的本地运行,而非云端运行,因此用户可以在 PC 上保留私人和专有数据。

为支持 AI 开发者,NVIDIA 与微软发布 DirectML 增强功能以加速最热门的基础 AI 模型之一的 Llama 2。除了全新性能标准,开发者现在有更多跨供应商部署可选。