微软发布LLMLingua,突破上下文长度限制,开创Prompt压缩技术新思路

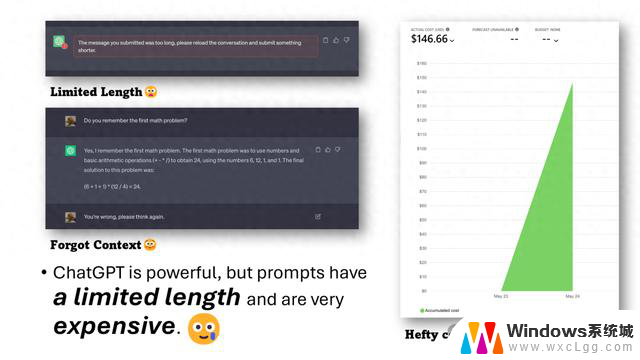

一般的解决思路是通过训练更优秀的大模型来解决,但众所周知,由于大模型的二次复杂度,Context window(上下文长度)提升相对困难。再加之直接使用OpenAI等云服务接口,无法更换模型的开发者来讲,如何扩展上下文长度呢?

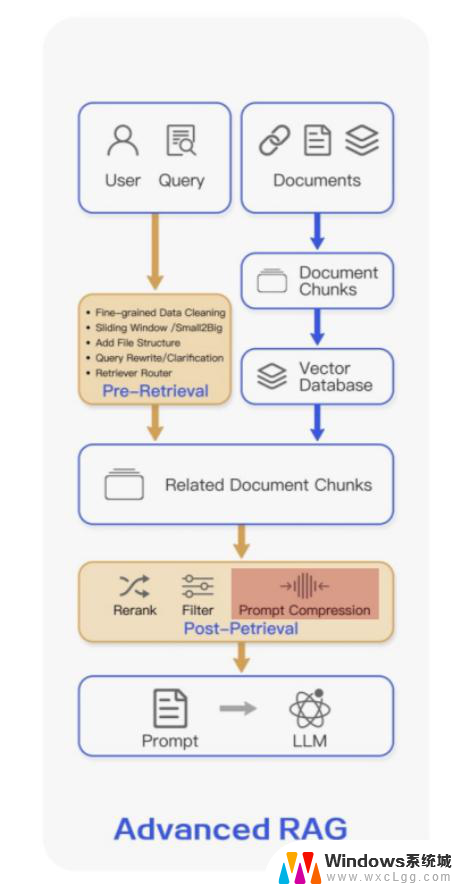

有一个比较直接的思路就是对Prompt进行压缩,它的基本假设就是自然语言本身是存在冗余的。在一些实际的高阶RAG架构中,Prompt压缩也可以作为一个模块内置在系统中。

比如,在langchain中,对于多轮的对话上下文进行压缩总结从而达到减少Prompt的目的。

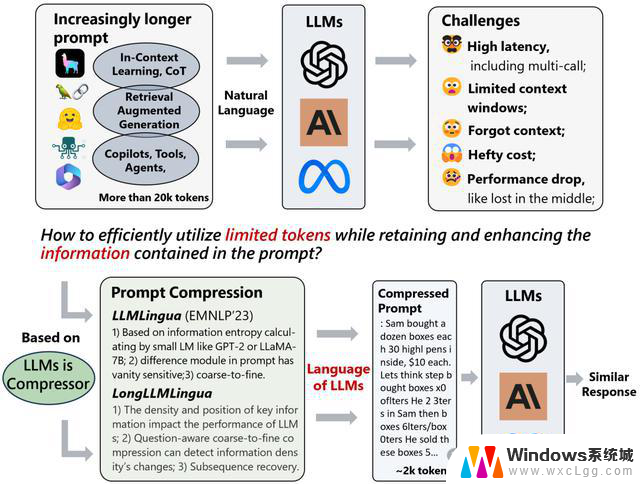

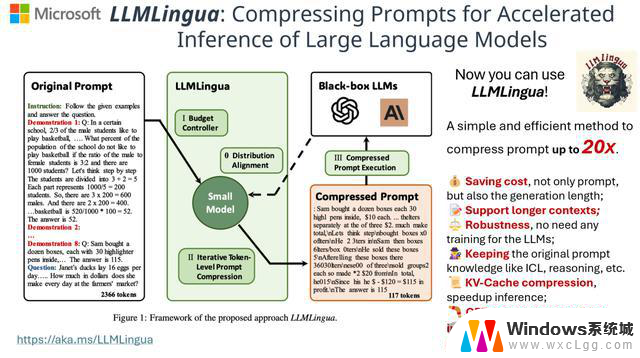

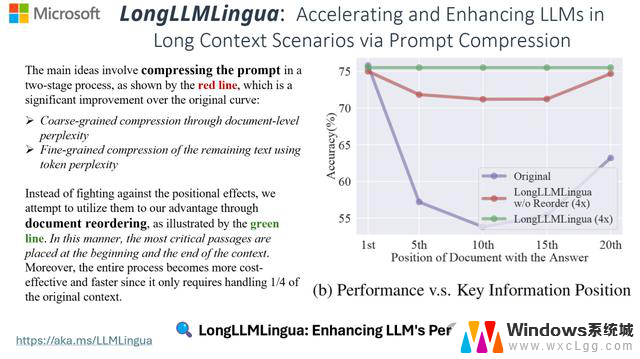

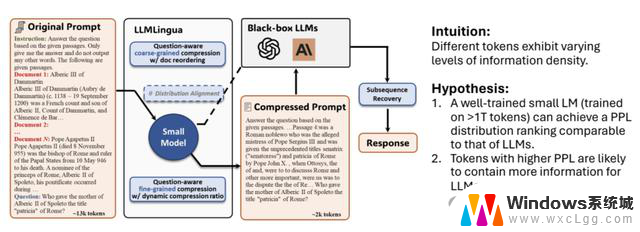

基于这样的思路,微软在十月份公布了一项他们的研究进展。称受论文Ilya的LLMs is Compressors的观点启发,他们开发了一款工具LLMLingua及LongLLMLingua,实现了 20 倍的压缩比和最小的性能损失 (LLMLingua),以及 17.1% 的 4 倍压缩 (LongLLMLingua) 的性能提升,进而达到加速模型推理、降低成本并提高下游性能的目的。

其实现的基本思路是通过训练一个小的模型来对原始的Prompt进行压缩,从而获得更小的Prompt,再提交给大模型生成,并对生成结果进行解压。

在此基础上论文还提出了如下的Insights:

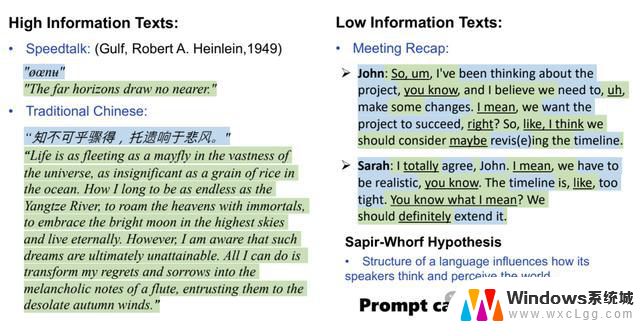

1.自然语言存在冗余性,信息量不尽相同。

2.LLM 可以理解被压缩后的Prompt。

3.LLMLingua是在语言完整性和压缩率之间进行权衡。

4.GPT-4 可以从被压缩的具有涌现能力的Prompt中恢复所有关键信息。(LLMLingua)

5.Prompt中关键信息的密度和位置会影响下游任务的性能。(LongLLMLingua)

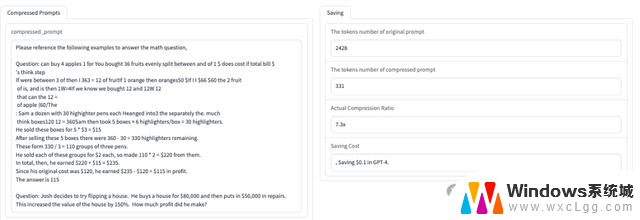

使用方法也比较简单:

除此之外,还提供了该工具的使用例子和压缩效果直观展示。

https://huggingface.co/spaces/microsoft/LLMLingua